ж‘ҳиҮӘпјҡ

http://www.blogjava.net/zhenandaci/archive/2009/03/01/257237.html

и®©жҲ‘еҶҚдёҖж¬ЎжҜ”иҫғе®Ңж•ҙзҡ„йҮҚеӨҚдёҖдёӢжҲ‘们иҰҒи§ЈеҶізҡ„й—®йўҳпјҡжҲ‘们жңүеұһдәҺдёӨдёӘзұ»еҲ«зҡ„ж ·жң¬зӮ№пјҲ并дёҚйҷҗе®ҡиҝҷдәӣзӮ№еңЁдәҢз»ҙз©әй—ҙдёӯпјүиӢҘе№ІпјҢеҰӮеӣҫпјҢ

еңҶеҪўзҡ„ж ·жң¬зӮ№е®ҡдёәжӯЈж ·жң¬пјҲиҝһеёҰзқҖпјҢжҲ‘们еҸҜд»ҘжҠҠжӯЈж ·жң¬жүҖеұһзҡ„зұ»еҸ«еҒҡжӯЈзұ»пјүпјҢж–№еҪўзҡ„зӮ№е®ҡдёәиҙҹдҫӢгҖӮжҲ‘们жғіжұӮеҫ—иҝҷж ·дёҖдёӘзәҝжҖ§еҮҪж•°пјҲеңЁnз»ҙз©әй—ҙдёӯзҡ„зәҝжҖ§еҮҪж•°пјүпјҡ

g(x)=wx+b

дҪҝеҫ—жүҖжңүеұһдәҺжӯЈзұ»зҡ„зӮ№x+д»Је…Ҙд»ҘеҗҺжңүg(x+)вүҘ1пјҢиҖҢжүҖжңүеұһдәҺиҙҹзұ»зҡ„зӮ№x-д»Је…ҘеҗҺжңүg(x-)вүӨ-1пјҲд№ӢжүҖд»ҘжҖ»и·ҹ1жҜ”иҫғпјҢж— и®әжӯЈдёҖиҝҳжҳҜиҙҹдёҖпјҢйғҪжҳҜеӣ дёәжҲ‘们еӣәе®ҡдәҶй—ҙйҡ”дёә1пјҢжіЁж„Ҹй—ҙйҡ”е’ҢеҮ дҪ•й—ҙйҡ”зҡ„еҢәеҲ«пјүгҖӮд»Је…Ҙg(x)еҗҺзҡ„еҖјеҰӮжһңеңЁ1е’Ң-1д№Ӣй—ҙпјҢжҲ‘们е°ұжӢ’з»қеҲӨж–ӯгҖӮ

жұӮиҝҷж ·зҡ„g(x)зҡ„иҝҮзЁӢе°ұжҳҜжұӮwпјҲдёҖдёӘnз»ҙеҗ‘йҮҸпјүе’ҢbпјҲдёҖдёӘе®һж•°пјүдёӨдёӘеҸӮж•°зҡ„иҝҮзЁӢпјҲдҪҶе®һйҷ…дёҠеҸӘйңҖиҰҒжұӮwпјҢжұӮеҫ—д»ҘеҗҺжүҫжҹҗдәӣж ·жң¬зӮ№д»Је…Ҙе°ұеҸҜд»ҘжұӮеҫ—bпјүгҖӮеӣ жӯӨеңЁжұӮg(x)зҡ„ж—¶еҖҷпјҢwжүҚжҳҜеҸҳйҮҸгҖӮ

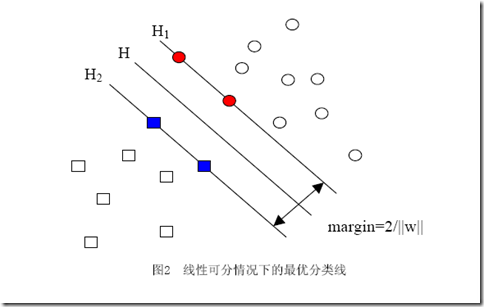

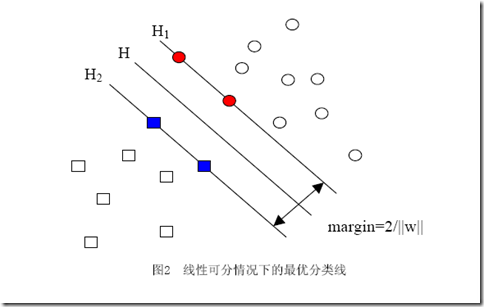

дҪ иӮҜе®ҡиғҪзңӢеҮәжқҘпјҢдёҖж—ҰжұӮеҮәдәҶwпјҲд№ҹе°ұжұӮеҮәдәҶbпјүпјҢйӮЈд№Ҳдёӯй—ҙзҡ„зӣҙзәҝHе°ұзҹҘйҒ“дәҶпјҲеӣ дёәе®ғе°ұжҳҜwx+b=0еҳӣпјҢе“Ҳе“ҲпјүпјҢйӮЈд№ҲH1е’ҢH2д№ҹе°ұзҹҘйҒ“дәҶпјҲеӣ дёәдёүиҖ…жҳҜе№іиЎҢзҡ„пјҢиҖҢдё”зӣёйҡ”зҡ„и·қзҰ»иҝҳжҳҜ||w||еҶіе®ҡзҡ„пјүгҖӮйӮЈд№ҲwжҳҜи°ҒеҶіе®ҡзҡ„пјҹжҳҫ然жҳҜдҪ з»ҷзҡ„ж ·жң¬еҶіе®ҡзҡ„пјҢдёҖж—ҰдҪ еңЁз©әй—ҙдёӯз»ҷеҮәдәҶйӮЈдәӣдёӘж ·жң¬зӮ№пјҢдёүжқЎзӣҙзәҝзҡ„дҪҚзҪ®е®һйҷ…дёҠе°ұе”ҜдёҖзЎ®е®ҡдәҶпјҲеӣ дёәжҲ‘们жұӮзҡ„жҳҜжңҖдјҳзҡ„йӮЈдёүжқЎпјҢеҪ“然жҳҜе”ҜдёҖзҡ„пјүпјҢжҲ‘们解дјҳеҢ–й—®йўҳзҡ„иҝҮзЁӢд№ҹеҸӘдёҚиҝҮжҳҜжҠҠиҝҷдёӘзЎ®е®ҡдәҶзҡ„дёңиҘҝз®—еҮәжқҘиҖҢе·ІгҖӮ

ж ·жң¬зЎ®е®ҡдәҶwпјҢз”Ёж•°еӯҰзҡ„иҜӯиЁҖжҸҸиҝ°пјҢе°ұжҳҜwеҸҜд»ҘиЎЁзӨәдёәж ·жң¬зҡ„жҹҗз§Қз»„еҗҲпјҡ

w=Оұ1x1+Оұ2x2+вҖҰ+Оұnxn

ејҸеӯҗдёӯзҡ„ОұiжҳҜдёҖдёӘдёҖдёӘзҡ„ж•°пјҲеңЁдёҘж јзҡ„иҜҒжҳҺиҝҮзЁӢдёӯпјҢиҝҷдәӣОұиў«з§°дёәжӢүж јжң—ж—Ҙд№ҳеӯҗпјүпјҢиҖҢxiжҳҜж ·жң¬зӮ№пјҢеӣ иҖҢжҳҜеҗ‘йҮҸпјҢnе°ұжҳҜжҖ»ж ·жң¬зӮ№зҡ„дёӘж•°гҖӮдёәдәҶж–№дҫҝжҸҸиҝ°пјҢд»ҘдёӢејҖе§ӢдёҘж јеҢәеҲ«ж•°еӯ—дёҺеҗ‘йҮҸзҡ„д№ҳз§Ҝе’Ңеҗ‘йҮҸй—ҙзҡ„д№ҳз§ҜпјҢжҲ‘дјҡз”ЁОұ1x1иЎЁзӨәж•°еӯ—е’Ңеҗ‘йҮҸзҡ„д№ҳз§ҜпјҢиҖҢз”Ё<x1,x2>иЎЁзӨәеҗ‘йҮҸx1,x2зҡ„еҶ…з§ҜпјҲд№ҹеҸ«зӮ№з§ҜпјҢжіЁж„ҸдёҺеҗ‘йҮҸеҸүз§Ҝзҡ„еҢәеҲ«пјүгҖӮеӣ жӯӨg(x)зҡ„иЎЁиҫҫејҸдёҘж јзҡ„еҪўејҸеә”иҜҘжҳҜпјҡ

g(x)=<w,x>+b

дҪҶжҳҜдёҠйқўзҡ„ејҸеӯҗиҝҳдёҚеӨҹеҘҪпјҢдҪ еӣһеӨҙзңӢзңӢеӣҫдёӯжӯЈж ·жң¬е’Ңиҙҹж ·жң¬зҡ„дҪҚзҪ®пјҢжғіеғҸдёҖдёӢпјҢжҲ‘дёҚеҠЁжүҖжңүзӮ№зҡ„дҪҚзҪ®пјҢиҖҢеҸӘжҳҜжҠҠе…¶дёӯдёҖдёӘжӯЈж ·жң¬зӮ№е®ҡдёәиҙҹж ·жң¬зӮ№пјҲд№ҹе°ұжҳҜжҠҠдёҖдёӘзӮ№зҡ„еҪўзҠ¶д»ҺеңҶеҪўеҸҳдёәж–№еҪўпјүпјҢз»“жһңжҖҺд№Ҳж ·пјҹдёүжқЎзӣҙзәҝйғҪеҝ…须移еҠЁпјҲеӣ дёәеҜ№иҝҷдёүжқЎзӣҙзәҝзҡ„иҰҒжұӮжҳҜеҝ…йЎ»жҠҠж–№еҪўе’ҢеңҶеҪўзҡ„зӮ№жӯЈзЎ®еҲҶејҖпјүпјҒиҝҷиҜҙжҳҺwдёҚд»…и·ҹж ·жң¬зӮ№зҡ„дҪҚзҪ®жңүе…іпјҢиҝҳи·ҹж ·жң¬зҡ„зұ»еҲ«жңүе…іпјҲд№ҹе°ұжҳҜе’Ңж ·жң¬зҡ„вҖңж ҮзӯҫвҖқжңүе…іпјүгҖӮеӣ жӯӨз”ЁдёӢйқўиҝҷдёӘејҸеӯҗиЎЁзӨәжүҚз®—е®Ңж•ҙпјҡ

w=Оұ1y1x1+Оұ2y2x2+вҖҰ+Оұnynxn пјҲејҸ1пјү

е…¶дёӯзҡ„yiе°ұжҳҜ第iдёӘж ·жң¬зҡ„ж ҮзӯҫпјҢе®ғзӯүдәҺ1жҲ–иҖ…-1гҖӮе…¶е®һд»ҘдёҠејҸеӯҗзҡ„йӮЈдёҖе ҶжӢүж јжң—ж—Ҙд№ҳеӯҗдёӯпјҢеҸӘжңүеҫҲе°‘зҡ„дёҖйғЁеҲҶдёҚзӯүдәҺ0пјҲдёҚзӯүдәҺ0жүҚеҜ№wиө·еҶіе®ҡдҪңз”ЁпјүпјҢиҝҷйғЁеҲҶдёҚзӯүдәҺ0зҡ„жӢүж јжң—ж—Ҙд№ҳеӯҗеҗҺйқўжүҖд№ҳзҡ„ж ·жң¬зӮ№пјҢе…¶е®һйғҪиҗҪеңЁH1е’ҢH2дёҠпјҢд№ҹжӯЈжҳҜиҝҷйғЁеҲҶж ·жң¬пјҲиҖҢдёҚйңҖиҰҒе…ЁйғЁж ·жң¬пјүе”ҜдёҖзҡ„зЎ®е®ҡдәҶеҲҶзұ»еҮҪж•°пјҢеҪ“然пјҢжӣҙдёҘж јзҡ„иҜҙпјҢиҝҷдәӣж ·жң¬зҡ„дёҖйғЁеҲҶе°ұеҸҜд»ҘзЎ®е®ҡпјҢеӣ дёәдҫӢеҰӮзЎ®е®ҡдёҖжқЎзӣҙзәҝпјҢеҸӘйңҖиҰҒдёӨдёӘзӮ№е°ұеҸҜд»ҘпјҢеҚідҫҝжңүдёүдә”дёӘйғҪиҗҪеңЁдёҠйқўпјҢжҲ‘们д№ҹдёҚжҳҜе…ЁйғҪйңҖиҰҒгҖӮиҝҷйғЁеҲҶжҲ‘们зңҹжӯЈйңҖиҰҒзҡ„ж ·жң¬зӮ№пјҢе°ұеҸ«еҒҡж”ҜжҢҒпјҲж’‘пјүеҗ‘йҮҸпјҒпјҲеҗҚеӯ—иҝҳжҢәеҪўиұЎеҗ§пјҢ他们вҖңж’‘вҖқиө·дәҶеҲҶз•Ңзәҝпјү

ејҸеӯҗд№ҹеҸҜд»Ҙз”ЁжұӮе’Ңз¬ҰеҸ·з®ҖеҶҷдёҖдёӢпјҡ

еӣ жӯӨеҺҹжқҘзҡ„g(x)иЎЁиҫҫејҸеҸҜд»ҘеҶҷдёәпјҡ

жіЁж„ҸејҸеӯҗдёӯxжүҚжҳҜеҸҳйҮҸпјҢд№ҹе°ұжҳҜдҪ иҰҒеҲҶзұ»е“ӘзҜҮж–ҮжЎЈпјҢе°ұжҠҠиҜҘж–ҮжЎЈзҡ„еҗ‘йҮҸиЎЁзӨәд»Је…ҘеҲ° xзҡ„дҪҚзҪ®пјҢиҖҢжүҖжңүзҡ„xiз»ҹз»ҹйғҪжҳҜе·ІзҹҘзҡ„ж ·жң¬гҖӮиҝҳжіЁж„ҸеҲ°ејҸеӯҗдёӯеҸӘжңүxiе’ҢxжҳҜеҗ‘йҮҸпјҢеӣ жӯӨдёҖйғЁеҲҶеҸҜд»Ҙд»ҺеҶ…з§Ҝз¬ҰеҸ·дёӯжӢҝеҮәжқҘпјҢеҫ—еҲ°g(x)зҡ„ејҸеӯҗдёәпјҡ

еҸ‘зҺ°дәҶд»Җд№ҲпјҹwдёҚи§Ғе•ҰпјҒд»ҺжұӮwеҸҳжҲҗдәҶжұӮОұгҖӮ

дҪҶиӮҜе®ҡжңүдәәдјҡиҜҙпјҢиҝҷ并没жңүжҠҠеҺҹй—®йўҳз®ҖеҢ–е‘ҖгҖӮеҳҝеҳҝпјҢе…¶е®һз®ҖеҢ–дәҶпјҢеҸӘдёҚиҝҮеңЁдҪ зңӢдёҚи§Ғзҡ„ең°ж–№пјҢд»Ҙиҝҷж ·зҡ„еҪўејҸжҸҸиҝ°й—®йўҳд»ҘеҗҺпјҢжҲ‘们зҡ„дјҳеҢ–й—®йўҳе°‘дәҶеҫҲеӨ§дёҖйғЁеҲҶдёҚзӯүејҸзәҰжқҹпјҲи®°еҫ—иҝҷжҳҜжҲ‘们解дёҚдәҶжһҒеҖјй—®йўҳзҡ„дёҮжҒ¶д№ӢжәҗпјүгҖӮдҪҶжҳҜжҺҘдёӢжқҘе…Ҳи·іиҝҮзәҝжҖ§еҲҶзұ»еҷЁжұӮи§Јзҡ„йғЁеҲҶпјҢжқҘзңӢзңӢ SVMеңЁзәҝжҖ§еҲҶзұ»еҷЁдёҠжүҖеҒҡзҡ„йҮҚеӨ§ж”№иҝӣвҖ”вҖ”ж ёеҮҪж•°гҖӮ

еҲҶдә«еҲ°пјҡ

зӣёе…іжҺЁиҚҗ

ж·ұе…Ҙжө…еҮәи®Іи§ЈSVMзҡ„еҺҹзҗҶе’Ңеә”з”ЁпјҢ...SVMе…Ҙй—ЁпјҲе…ӯпјүзәҝжҖ§еҲҶзұ»еҷЁзҡ„жұӮи§ЈвҖ”вҖ”й—®йўҳзҡ„иҪ¬еҢ–пјҢзӣҙи§Ӯи§’еәҰ SVMе…Ҙй—ЁпјҲдёғпјүдёәдҪ•йңҖиҰҒж ёеҮҪж•° SVMе…Ҙй—ЁпјҲе…«пјүжқҫејӣеҸҳйҮҸгҖӮ SVMе…Ҙй—ЁпјҲд№қпјүжқҫејӣеҸҳйҮҸпјҲз»ӯпјүгҖӮ SVMе…Ҙй—ЁпјҲеҚҒпјүе°ҶSVMз”ЁдәҺеӨҡзұ»еҲҶзұ»гҖӮ

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲsupport vector machines, SVMпјүжҳҜдёҖз§ҚдәҢеҲҶзұ»жЁЎеһӢпјҢе®ғзҡ„еҹәжң¬жЁЎеһӢжҳҜе®ҡд№үеңЁзү№еҫҒз©әй—ҙдёҠзҡ„й—ҙйҡ”жңҖеӨ§зҡ„зәҝжҖ§еҲҶзұ»еҷЁпјҢй—ҙйҡ”жңҖеӨ§дҪҝе®ғжңүеҲ«дәҺж„ҹзҹҘжңәпјӣSVMиҝҳеҢ…жӢ¬ж ёжҠҖе·§пјҢиҝҷдҪҝе®ғжҲҗдёәе®һиҙЁдёҠзҡ„йқһзәҝжҖ§еҲҶзұ»еҷЁгҖӮSVMзҡ„зҡ„еӯҰд№ ...

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲsupport vector machines, SVMпјүжҳҜдёҖз§ҚдәҢеҲҶзұ»жЁЎеһӢпјҢе®ғзҡ„еҹәжң¬жЁЎеһӢжҳҜе®ҡд№үеңЁзү№еҫҒз©әй—ҙдёҠзҡ„й—ҙйҡ”жңҖеӨ§зҡ„зәҝжҖ§еҲҶзұ»еҷЁпјҢй—ҙйҡ”жңҖеӨ§дҪҝе®ғжңүеҲ«дәҺж„ҹзҹҘжңәпјӣSVMиҝҳеҢ…жӢ¬ж ёжҠҖе·§пјҢиҝҷдҪҝе®ғжҲҗдёәе®һиҙЁдёҠзҡ„йқһзәҝжҖ§еҲҶзұ»еҷЁгҖӮSVMзҡ„зҡ„еӯҰд№ ...

жң¬ж–ҮжқҘжәҗдәҺcsdnпјҢд»Ӣз»ҚдәҶSVMпјҢзәҝжҖ§еҲҶзұ»еҷЁпјҢзәҝжҖ§еҲҶзұ»еҷЁзҡ„жұӮи§ЈпјҢжқҫејӣеҸҳйҮҸпјҢSVMз”ЁдәҺеӨҡзұ»еҲҶзұ»зӯүгҖӮж”ҜжҢҒеҗ‘йҮҸжңә(SupportVectorMachine)жҳҜCortesе’ҢVapnikдәҺ1995е№ҙйҰ–е…ҲжҸҗеҮәзҡ„пјҢе®ғеңЁи§ЈеҶіе°Ҹж ·жң¬гҖҒйқһзәҝжҖ§еҸҠй«ҳз»ҙжЁЎејҸиҜҶеҲ«дёӯиЎЁзҺ°еҮә...

ж”ҜжҢҒеҗ‘йҮҸжңәпјҡж”ҜжҢҒеҗ‘йҮҸжңәпјҲSupport Vector Machine, SVMпјүжҳҜдёҖзұ»жҢүзӣ‘зқЈеӯҰд№ пјҲsupervised learningпјүж–№ејҸеҜ№ж•°жҚ®иҝӣиЎҢдәҢе…ғеҲҶзұ»зҡ„е№ҝд№үзәҝжҖ§еҲҶзұ»еҷЁпјҲgeneralized linear classifierпјүпјҢе…¶еҶізӯ–иҫ№з•ҢжҳҜеҜ№еӯҰд№ ж ·жң¬жұӮи§Јзҡ„жңҖеӨ§...

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲSupport Vector Machine, SVMпјүжҳҜдёҖзұ»жҢүзӣ‘зқЈеӯҰд№ пјҲsupervised learningпјүж–№ејҸеҜ№ж•°жҚ®иҝӣиЎҢдәҢе…ғеҲҶзұ»зҡ„е№ҝд№үзәҝжҖ§еҲҶзұ»еҷЁпјҲgeneralized linear classifierпјүпјҢе…¶еҶізӯ–иҫ№з•ҢжҳҜеҜ№еӯҰд№ ж ·жң¬жұӮи§Јзҡ„жңҖеӨ§иҫ№и·қи¶…е№ійқў...

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲSupport Vector Machine, SVMпјүжҳҜдёҖзұ»жҢүзӣ‘зқЈеӯҰд№ пјҲsupervised learningпјүж–№ејҸеҜ№ж•°жҚ®иҝӣиЎҢдәҢе…ғеҲҶзұ»зҡ„е№ҝд№үзәҝжҖ§еҲҶзұ»еҷЁпјҲgeneralized linear classifierпјүпјҢе…¶еҶізӯ–иҫ№з•ҢжҳҜеҜ№еӯҰд№ ж ·жң¬жұӮи§Јзҡ„жңҖеӨ§иҫ№и·қи¶…е№ійқўгҖӮ

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲSVMпјүжҳҜдёҖз§ҚеҲҶзұ»жЁЎеһӢпјҢе®ғзҡ„еҹәжң¬жЁЎеһӢжҳҜе®ҡд№үеңЁзү№еҫҒз©әй—ҙдёҠзҡ„й—ҙйҡ”жңҖеӨ§зҡ„зәҝжҖ§еҲҶзұ»еҷЁпјҢеӯҰд№ зӯ–з•ҘжҳҜй—ҙйҡ”жңҖеӨ§еҢ–пјҢжңҖз»ҲеҸҜиҪ¬еҢ–дёәдёҖдёӘеҮёдәҢ次规еҲ’й—®йўҳзҡ„жұӮи§ЈгҖӮеҢ…еҗ«дёүдёӘз”ұз®ҖиҮіз№Ғзҡ„жЁЎеһӢпјҡзәҝжҖ§еҸҜеҲҶж”ҜжҢҒеҗ‘йҮҸжңәгҖҒзәҝжҖ§ж”ҜжҢҒ...

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲSupport Vector Machine, SVMпјүжҳҜдёҖзұ»жҢүзӣ‘зқЈеӯҰд№ пјҲsupervised learningпјүж–№ејҸеҜ№ж•°жҚ®иҝӣиЎҢдәҢе…ғеҲҶзұ»зҡ„е№ҝд№үзәҝжҖ§еҲҶзұ»еҷЁпјҲgeneralized linear classifierпјүпјҢе…¶еҶізӯ–иҫ№з•ҢжҳҜеҜ№еӯҰд№ ж ·жң¬жұӮи§Јзҡ„жңҖеӨ§иҫ№и·қи¶…е№ійқў...

第15з« SVMзҡ„еҸӮж•°дјҳеҢ–вҖ”вҖ”еҰӮдҪ•жӣҙеҘҪзҡ„жҸҗеҚҮеҲҶзұ»еҷЁзҡ„жҖ§иғҪ 第16з« еҹәдәҺSVMзҡ„еӣһеҪ’йў„жөӢеҲҶжһҗвҖ”вҖ”дёҠиҜҒжҢҮж•°ејҖзӣҳжҢҮж•°йў„жөӢ. 第17з« еҹәдәҺSVMзҡ„дҝЎжҒҜзІ’еҢ–ж—¶еәҸеӣһеҪ’йў„жөӢвҖ”вҖ”дёҠиҜҒжҢҮж•°ејҖзӣҳжҢҮж•°еҸҳеҢ–и¶ӢеҠҝе’ҢеҸҳеҢ–з©әй—ҙйў„жөӢ 第18з« еҹәдәҺSVMзҡ„...

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲSupport Vector Machine, SVMпјүжҳҜдёҖзұ»жҢүзӣ‘зқЈеӯҰд№ пјҲsupervised learningпјүж–№ејҸеҜ№ж•°жҚ®иҝӣиЎҢдәҢе…ғеҲҶзұ»зҡ„е№ҝд№үзәҝжҖ§еҲҶзұ»еҷЁпјҲgeneralized linear classifierпјүпјҢе…¶еҶізӯ–иҫ№з•ҢжҳҜеҜ№еӯҰд№ ж ·жң¬жұӮи§Јзҡ„жңҖеӨ§иҫ№и·қи¶…е№ійқў...

ж”ҜжҢҒеҗ‘йҮҸжңәпјҲSupport Vector Machine, SVMпјүжҳҜдёҖзұ»жҢүзӣ‘зқЈеӯҰд№ пјҲsupervised learningпјүж–№ејҸеҜ№ж•°жҚ®иҝӣиЎҢдәҢе…ғеҲҶзұ»зҡ„е№ҝд№үзәҝжҖ§еҲҶзұ»еҷЁпјҲgeneralized linear classifierпјүпјҢе…¶еҶізӯ–иҫ№з•ҢжҳҜеҜ№еӯҰд№ ж ·жң¬жұӮи§Јзҡ„жңҖеӨ§иҫ№и·қи¶…е№ійқў...

SVMд№ӢзәҝжҖ§еҸҜеҲҶж—¶жҚҹеӨұеҮҪж•°зҡ„жұӮи§Ј-еҜ№w,bеҸҳйҮҸжұӮеҒҸеҜј09_SVMд№ӢзәҝжҖ§еҸҜеҲҶж—¶жҚҹеӨұеҮҪж•°зҡ„жұӮи§Ј-еҜ№ОІеҸҳйҮҸжұӮи§Ј.10_SVMд№ӢзәҝжҖ§еҸҜеҲҶж—¶з®—жі•ж•ҙдҪ“жөҒзЁӢ11_SVMд№ӢзәҝжҖ§еҸҜеҲҶж—¶жЎҲдҫӢ12_SVMд№ӢзәҝжҖ§дёҚеҸҜеҲҶж—¶иҪҜй—ҙйҡ”д»Ӣз»Қ13_SVMд№ӢзәҝжҖ§дёҚеҸҜеҲҶж—¶иҪҜй—ҙйҡ”...

第15з« SVMзҡ„еҸӮж•°дјҳеҢ–вҖ”вҖ”еҰӮдҪ•жӣҙеҘҪзҡ„жҸҗеҚҮеҲҶзұ»еҷЁзҡ„жҖ§иғҪ 第16з« еҹәдәҺSVMзҡ„еӣһеҪ’йў„жөӢеҲҶжһҗвҖ”вҖ”дёҠиҜҒжҢҮж•°ејҖзӣҳжҢҮж•°йў„жөӢ. 第17з« еҹәдәҺSVMзҡ„дҝЎжҒҜзІ’еҢ–ж—¶еәҸеӣһеҪ’йў„жөӢвҖ”вҖ”дёҠиҜҒжҢҮж•°ејҖзӣҳжҢҮж•°еҸҳеҢ–и¶ӢеҠҝе’ҢеҸҳеҢ–з©әй—ҙйў„жөӢ 第18з« еҹәдәҺSVMзҡ„...

SVMпјүжҳҜдёҖзұ»жҢүзӣ‘зқЈеӯҰд№ пјҲsupervised learningпјүж–№ејҸеҜ№ж•°жҚ®иҝӣиЎҢдәҢе…ғеҲҶзұ»зҡ„е№ҝд№үзәҝжҖ§еҲҶзұ»еҷЁпјҲgeneralized linear classifierпјүпјҢе…¶еҶізӯ–иҫ№з•ҢжҳҜеҜ№еӯҰд№ ж ·жң¬жұӮи§Јзҡ„жңҖеӨ§иҫ№и·қи¶…е№ійқўпјҲmaximum-margin hyperplaneпјүгҖӮ...

ж‘ҳ иҰҒ еј•е…ҘдәҶе°әеәҰеҢ–еҮёеЈі (Scaledconvexhull,SCH) зҡ„жҰӮеҝө, жҠҠжұӮи§ЈзәҝжҖ§дёҚеҸҜеҲҶж”ҜжҢҒеҗ‘йҮҸжңә(SVM) зҡ„й—®йўҳиҪ¬еҢ–дёәи®Ўз®—дёӨзұ»и®ӯз»ғж ·жң¬еҲҶеҲ«з”ҹжҲҗзҡ„е°әеәҰеҢ–еҮёеЈій—ҙзҡ„жңҖиҝ‘зӮ№еҜ№зҡ„й—®йўҳ.

SVMдҪҝз”Ёй“°й“ҫжҚҹеӨұеҮҪж•°пјҲhinge lossпјүи®Ўз®—з»ҸйӘҢйЈҺйҷ©пјҲempirical riskпјү并еңЁжұӮи§Јзі»з»ҹдёӯеҠ е…ҘдәҶжӯЈеҲҷеҢ–йЎ№д»ҘдјҳеҢ–з»“жһ„йЈҺйҷ©пјҲstructural riskпјүпјҢжҳҜдёҖдёӘе…·жңүзЁҖз–ҸжҖ§е’ҢзЁіеҒҘжҖ§зҡ„еҲҶзұ»еҷЁ [2] гҖӮSVMеҸҜд»ҘйҖҡиҝҮж ёж–№жі•пјҲkernel methodпјү...

е…¬ејҖиҜҫ笔记8вҖ”вҖ”вҖ”ж ёжҠҖжі•гҖҒиҪҜй—ҙйҡ”еҲҶзұ»еҷЁгҖҒSMOз®—жі• е…¬ејҖиҜҫ笔记9вҖ”еҒҸе·®/ж–№е·®гҖҒз»ҸйӘҢйЈҺйҷ©жңҖе°ҸеҢ–гҖҒиҒ”еҗҲз•ҢгҖҒдёҖиҮҙ收ж•ӣ е…¬ејҖиҜҫ笔记10вҖ”вҖ”VCз»ҙгҖҒжЁЎеһӢйҖүжӢ©гҖҒзү№еҫҒйҖүжӢ© е…¬ејҖиҜҫ笔记11вҖ”вҖ”иҙқеҸ¶ж–ҜжӯЈеҲҷеҢ–гҖҒеңЁзәҝеӯҰд№ гҖҒMLеә”з”Ёе»әи®® е…¬ејҖ...

LSVM v 3.0 --------- еҝ«йҖҹзәҝжҖ§ SVM дәҢе…ғжұӮи§ЈеҷЁе·Ҙе…·з®ұпјҢеҰӮ PEGASOS/LIBLINEARгҖӮ жӯӨе·Ҙе…·з®ұйҖҡиҝҮдёӨдёӘжңҖеёёи§Ғзҡ„ mex ж–Ү件жҸҗдҫӣеҝ«йҖҹе®һзҺ°з”ЁдәҺдәҢе…ғеҲҶзұ»зҡ„жөҒиЎҢзәҝжҖ§ SVM з®—жі•пјҡPEGASOS [1] е’Ң LIBLINEAR [2]гҖӮ иҜҘе·Ҙе…·з®ұеҸҜд»Ҙ...